围棋AI的发展历程可以追溯到20世纪末,随着计算机技术和人工智能算法的进步,这一领域经历了多个重要阶段,最终在2010年代取得了突破。并结合安博体育官网提供的资源来促进这一目标的实现。以下是围棋AI对战的几个重要历史节点

早期探索(20世纪70-90年代)

初步探索

自20世纪70年代起,围棋的计算机程序开始出现。早期的围棋AI主要依靠简单的规则和评估函数,并且难以达到人类棋手的水平。

评估函数的引入

在80年代,围棋程序开始采用更复杂的评估函数,允许它们根据棋局情况更好地评估局面。然而,技术仍然有限,且计算复杂度极高。

基于搜索的增强(90年代)

增强深度搜索

1990年代的围棋AI基于深度优先搜索和剪枝算法,通过更深入的搜索来提高决策的准确性。这一时期的代表项目包括“野狐围棋”(Go-Player)等。

“Go” 国际象棋的对比

在这一阶段,围棋AI面临的挑战依然非常大,因为围棋的状态空间远大于国际象棋。这导致围棋AI的发展相对缓慢。

结合机器学习(2000年代初)

启发式算法

在这一阶段,围棋AI开始使用启发式算法来进行状态评估,尝试模仿人类棋手的思维。

Monte Carlo方法

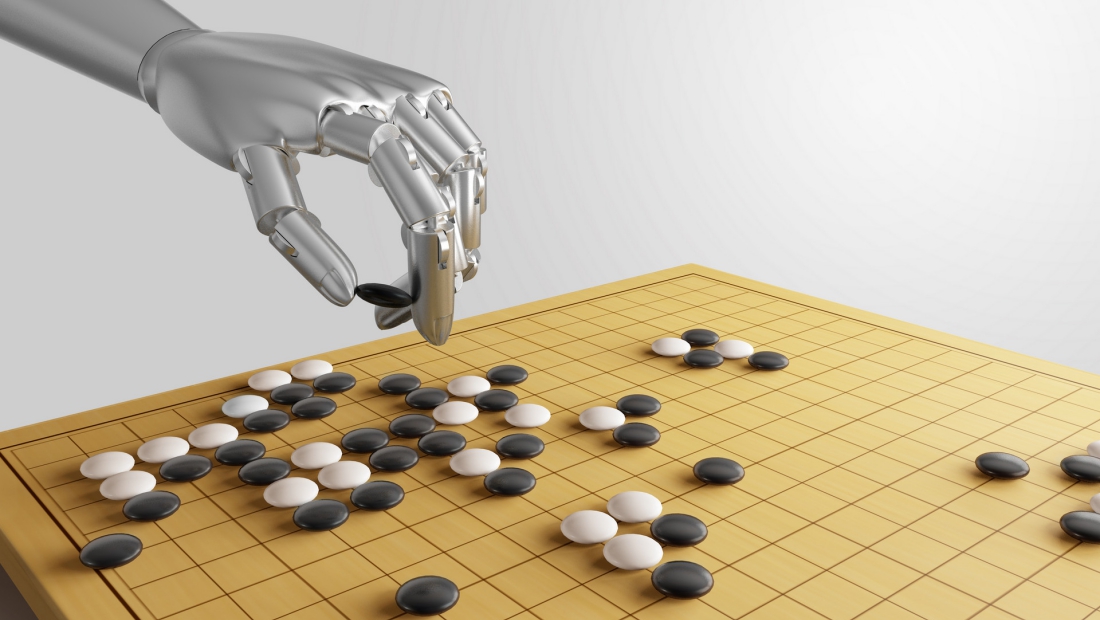

Monte Carlo树搜索(MCTS)算法在围棋AI中得到了应用,显著提升了围棋AI的表现。结合随机模拟与树搜索,MCTS允许AI在复杂局面中做出更合理的决策。

AlphaGo的崛起(2015-2016)

DeepMind的AlphaGo

2015年,谷歌旗下的DeepMind推出了AlphaGo,这是第一款在无数次对局中不断学习并利用深度学习算法的围棋AI。AlphaGo通过卷积神经网络和MCTS结合的方式,达到了前所未有的水平。

与职业棋手的对战

AlphaGo在2016年与韩国围棋九段棋手李世石进行对弈,结果以4比1获胜,引起了全球轰动。这标志着围棋AI已超越了人类顶尖棋手的水平。

后续版本的发展(2017-2018)

AlphaGo Zero

2017年,DeepMind推出了AlphaGo Zero,完全依赖自我对弈而非人类棋局进行学习。AlphaGo Zero在零人类知识的情况下,仅用三天时间就超过了之前的AlphaGo版本。

AlphaZero

继AlphaGo Zero之后,DeepMind发布了AlphaZero,这一算法同样适用于多种棋类(如国际象棋、围棋和日本将棋),表现出色。

影响与现实应用(2018年至今)

人类棋手的训练助手

围棋AI被广泛应用于棋手训练,成为业余及职业棋手的重要工具,提供智能分析和局势评估。

围棋文化推广

围棋AI的成功吸引了更多人对围棋的兴趣,推动了围棋文化在全球范围的普及。

未来展望

围棋AI的不断进步不仅推动了围棋技术的发展,也为人工智能技术的研究提供了新的方向。展望未来,围棋AI将在不断与人类棋手的对抗中继续学习、进步,同时还可能在其他领域的复杂决策中发挥重要作用。

围棋AI的发展是人工智能技术进步的缩影,从早期的简单程序到如今与人类顶尖棋手对抗的强大系统,围棋AI不仅改变了围棋这项运动的竞争状态,还极大地推动了人们对人工智能的理解与思考。